Meta анонсировала новую линейку ИИ-моделей — Llama 4, которые умеют работать с текстом, изображениями и видео одновременно. Две версии — Scout и Maverick — уже доступны разработчикам через платформы llama.com и Hugging Face. В ближайшее время они появятся и в приложениях Meta AI: WhatsApp, Messenger и Instagram.

Главная особенность — раннее объединение разных типов данных: модели учатся воспринимать текст и изображения вместе, а не по отдельности.

Что умеет Llama 4 Scout

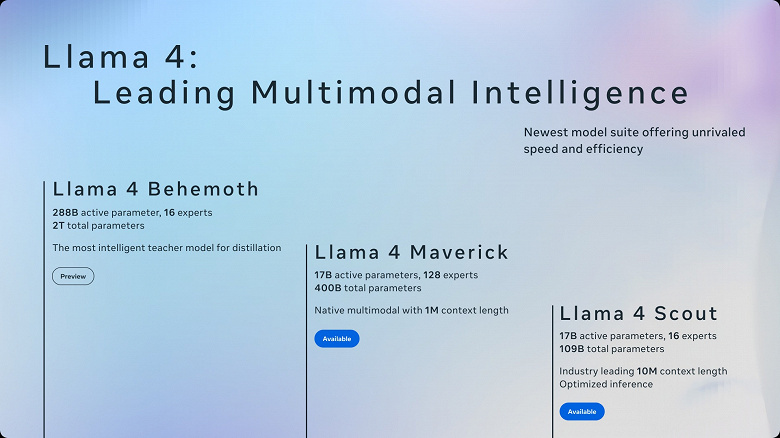

Scout — компактная модель (17 млрд активных параметров), которая может обрабатывать до 48 изображений за один запрос. Она работает даже на одной видеокарте NVIDIA H100 и способна анализировать до 10 миллионов токенов в контексте — это примерно 20 часов видео или 5000 страниц текста. По скорости и эффективности она обходит модели аналогичного класса, например, Google Gemma 3.

Что умеет Llama 4 Maverick

Maverick — более мощная серверная модель (400 млрд параметров), которая показывает производительность на уровне GPT-4.5. Она предназначена для сложных задач — логического анализа, программирования и работы с большими массивами данных. Модель также использует 10 миллионов токенов контекста и запускается на одной DGX-ноде с 8 GPU.

Обе модели были обучены на массивном датасете в 30 трлн токенов, включая тексты на 200 языках. Причем по 100 языкам в выборке собрано не менее 1 млрд примеров — это делает модели особенно полезными в регионах с малораспространёнными языками.

Meta планирует развивать подход узкоспециализированных ИИ, которые точнее решают прикладные задачи и обходятся дешевле в использовании. Новые модели уже находят применение в медицине, Big Data, переводах и финтехе.

Презентация следующей фазы развития состоится 29 апреля на LlamaCon, где Meta покажет ИИ с еще более продвинутым логическим мышлением.